Hallo !Friendica Support ich habe seit Montagabend das Problem, dass mein System im Speziellen die CPU auf Anschlag läuft. Im Verdacht habe ich den Worker.

Wurde in diesem Bereich etwas geändert?

Verwendete Version:

Auf welche Stichwörter soll/kann ich im Friendica-Log (Info) mal suchen?

@Friendica Support

Wurde in diesem Bereich etwas geändert?

Verwendete Version:

Friendica 'Giant Rhubarb' 2022.09-dev - 1474Auf welche Stichwörter soll/kann ich im Friendica-Log (Info) mal suchen?

@Friendica Support

Michael 🇺🇦

•Schaue bitte per

topoderhtopwelche Prozesse wie viel Last erzeugen und wie Deine Load im Allgemeinen ist. (Bei mir ist die Load derzeit um 1 und die CPUs laufen so zwischen 10 und 40%)Tuxi ⁂

•Hier mal der Load- und CPU-Verlauf der letzten sieben Tage. MAn sieht sehr schön wann das Problem losging:

Aktuell verursachen laut htop zwei von drei laufende Workerprozess so um die 80 Prozent CPU-Last.

Tuxi ⁂

•P.S.: Ich sehe auch gerade, dass vermutlich wegen dieses Problems bei weiten noch nicht alle von mir erstellten Antworten mit weiteren hinweisen hier an das @Friendica Support übertragen wurden.

Roland Häder🇩🇪

•killall -KILL php7.4-fpmrauswirft.Tuxi ⁂

•Ich bin schon seit "ewigen" Zeiten auf 7.4. Bis Montagabend gab es nie Probleme damit.

Michael 🇺🇦

•Tobias

•Roland Häder🇩🇪

•renice 19 $(pidof php)"netter" gemacht, damit ist er etwas langsamer, dafuer aber bremst er nicht FPM und auch nicht die MariaDB aus.Tuxi ⁂

•Der Hintergrundprozess (worker) wurde zuletzt um 2022-07-27 05:50:16 UTC ausgeführt. Das war vor mehr als einer Stunde. Bitte überprüfe deine crontab-Einstellungen.Die Workerprozesse laufen für meinen Geschmack auch deutlich zu lange?

Michael 🇺🇦

•Ich muss hier noch mein System in einen stabilen Zustand bringen und erstelle dann einen PR dafür.

Roland Häder🇩🇪

•renice 19 $(pidof php), dann sollten die wenigstens dein System nicht ausbremsen. Hier haben die selten so lange gebraucht, die Warteschlange abzuarbeiten.Tuxi ⁂

•Direkt auf der Konsole ausführen?

Was macht dieser Befehl?

Roland Häder🇩🇪

•Roland Häder🇩🇪

•man renicezeigt hier folgendes an:... show more

man renicezeigt hier folgendes an:Tuxi ⁂

•Aborted connection 73 to db: 'dbname' user: 'username' host: 'localhost' (Got an error reading communication packets)Tuxi ⁂

•Luca Nucifora

•- stop worker

- put friendica in maintenance mode

- restart mariadb

- optimize friendica db

- switch off maintenance mode

- start worker

Tuxi ⁂

•What do you mean by "optimize friendica db"?

Luca Nucifora

•Roland Häder🇩🇪

•Tuxi ⁂

•Hier sieht man schön einen Vergleich der Load und CPU. Ab 09:00 habe ich damit begonnen, Workerprozesse die ca. 70 Prozent Last verursachen manuell zu killen.

Michael 🇺🇦

•Tuxi ⁂

•Ohaaaa..... Ich habe gerade ein tail -f kombiniert mit einem grep auf eine der Amoklaufenden Workerprozess-ID gemacht. Da überschlägt sich ja das Log. Hiermal ein Auszug:

... show more

Ohaaaa..... Ich habe gerade ein tail -f kombiniert mit einem grep auf eine der Amoklaufenden Workerprozess-ID gemacht. Da überschlägt sich ja das Log. Hiermal ein Auszug:

Kannst Du das iwas rauslesen?

Wilhelm

•Tuxi ⁂

•Sorry.....

Wilhelm

•Roland Häder🇩🇪

•Tuxi ⁂

•Japp hab ich jetzt gemacht.... Sorry nochmal. Bin gewohnt das bei mir im Browser solch lange Sachen autom. zusammengeklappt werden. Habe dabei allerdings nicht die App-User bedacht.

Wilhelm

•hackbyte Antifa (friendica) 13HB1

•Tuxi ⁂

•Nö den hab ich gestern (Nachmittag?) noch gelöscht. 🤔

Tuxi ⁂

•Ohaaaa..... Ich habe gerade ein tail -f kombiniert mit einem grep auf eine der Amoklaufenden Workerprozess-ID gemacht. Da überschlägt sich ja das Log. Hier mal ein Auszug --> https://bin.disroot.org/?c29e176f4b087ad3#2xzGgW9c8nLt6AUwMc3kX1RcwsNW7xBg5SHDFTw4Xu6y

Montag

•Tobias

•git checkout 37c3a92d2cb6bc2bd9632a8d5bf2ace371dbb89aIm Friendica Verzeichnis. Wenn Michael da neue Ideen zum Testen hat, werde ich die dann auch austesten.

Roland Häder🇩🇪

•git reset --hard <commit-id>und bleibe somit auf dem Zweig verbunden, nur halt auf einen aelteren Commit.Tuxi ⁂

•Reicht da ein

git checkout 37c3a92d2cb6bc2bd9632a8d5bf2ace371dbb89aauf der Konsole aus oder muss man da auch noch was anderes machen?Tobias

•git reset --hard 37c3a92d2cb6bc2bd9632a8d5bf2ace371dbb89awas Roland vorgeschlagen hatte.Roland Häder🇩🇪

•-b tempanhaengen. Damit wird eine Branchtempmit dem Stand vom Kommit37c3a92d2cb6bc2bd9632a8d5bf2ace371dbb89aerzeugt. Wenn spaeter der Fehler aufdevelopoder wo du auch drauf bist (ich wuerde eine geziehlte Version empfehlen,stablekoennte auch klappen) behoben, kannst du mitgit checkout develop(oder auf welche Branch auch immer!) du wieder zurueckwechseln. Bitte vergesse die noetigen Schritte wie./bin/composer.phar install --no-dev && ./bin/console dbstructure update && ./bin/console postupdate, sowie das Neustarten des Workers nicht. 😀Tuxi ⁂

•Welches Vorgehen ist besser? Und ich zerschieße mir da nichts?

Roland Häder🇩🇪

•Steffen K9 🐰

•Roland Häder🇩🇪

•Steffen K9 🐰

•Roland Häder🇩🇪

•Roland Häder🇩🇪

•Tuxi ⁂

•Ach kam gestern noch was? Gleich mal sehen.....

Michael 🇺🇦

•Tobias

•Klar ist jetzt nur eine Momentaufnahme, aber die Worker-Queue ist so gut wie leer ( 13 - 8 ). Aber bitte sag mir das es wieder besser wird, oder es eine versteckte Option gibt mit der ich das regeln kann 😉

Michael 🇺🇦

•Das ist echt schräg. Auf meiner Kiste sieht es wie folgt aus:

Die Load schwankt in der Regel so zwischen 1,5 und 3 und die Kerne liegen recht häufig im einstelligen Bereich.

Kannst Du per

htop,iotopund Co. schauen, wo das System langsam ist?Tuxi ⁂

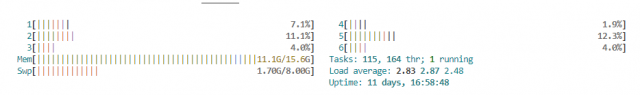

•Hier bei mir schaut es Stand jetzt so aus:

Und wenn überhaupt, wird die Warteschlange extremst langsam abgebaut.

Michael 🇺🇦

•Tobias

•Was ich sehe sind PHP8 Prozesse und die MariaDB die sich in h/top abwechseln und die die Spitzenplätze einnehmen. Wenn ich mit mytop rein schaue, werden immer nur ein, zwei aktuelle Befehle angezeigt, da scheint nichts lang laufendes zu sein.

Eigentlich hatte ich das System mal so eingestellt, dass nichts an neuen Accounts gesucht werden soll und auch keine Threads Vervollständigt werden sollen. Oder Threads importiert werden sollen auf die Kontakte reagiert haben. Wird halt jetzt trotzdem gemacht und verschwendet System Ressourcen. Das mag auf Knoten sinnvoll sein, auf denen Menschen in der Gemeinschaftsseite stöbern um in der globalen Timeline zu sehen was es noch so interessantes gibt, aber die globale Timeline ist bei mir auf dem Familien-Knoten deaktiviert.

Tobias

•Tobias

•Tobias

•Michael 🇺🇦

•Michael 🇺🇦

•Tobias

•Du hattest mir mal gesagt, das geht im Moment nicht anders und dafür sollte die Zeit nach der nicht erwünschte Nachrichten gelöscht werden sollen auf 1 gesetzt werden, s.d. die wenigstens nach einem Tag wieder gelöscht werden.

Michael 🇺🇦

•Tobias

•Michael 🇺🇦

•Tuxi ⁂

•Habe vor ca. 30 Minuten ein git pull gemacht. Werde das System weiter beobachten und berichten. Jetzt läuft für das erste der Worker voll nachdem seit gestern Abend ~ 21:00 keiner mehr gelaufen ist.

Michael 🇺🇦

•Tuxi ⁂

•Was mir eben auffällt, dass auch mein Platte voll läuft. Von gestern Morgen auf heute Morgen um gut 20 GB. Das ist untypisch.

Michael 🇺🇦

•Tobias

•Tuxi ⁂

•Ja habe ich. 😀

Tobias likes this.

Tuxi ⁂

•Nachtrag: Nachdem ich die Workerprozesse, MySQL und PHP-FPM neu gestartet hatte wurde ~25 GB Plattenplatz freigegeben.

Tuxi ⁂

•Anscheinend hat das Update keine Lösung des Problems gebracht:

Die CPU-Last steigt wieder allerdings scheint der Load nicht zu steigen. 🤔

Auch wird die Warteschlange (aktuell gut 2500) noch abgebaut.

Die rot eingezeichnete Linie ist der Zeitpunkt, an dem ich das Update gemacht habe und danach MySQL und PHP-FPM neu gestartet habe.

Die gelb eingezeichnete Linie war heute Morgen der Neustart der Workerprozesse sowie MySQL und PHP-FPM.

Michael 🇺🇦

•Tuxi ⁂

•Was meinst Du mit "normale Tätigkeiten"? Prozesse außerhalb vonFriendica?

Michael 🇺🇦

•Tuxi ⁂

•Was mir jetzt schon auffällt: Erstellte Beiträge von mir werden jetzt wesentlich schneller versendet. 👍

Tuxi ⁂

•Kann das auf einmal so explodieren oder ist da etwas anderes im argen?

Michael 🇺🇦

•Setze dazu den Log-Level mindestens auf "notice". Dann wirst Du Einträge wie diese hier sehen:

... show more

Setze dazu den Log-Level mindestens auf "notice". Dann wirst Du Einträge wie diese hier sehen:

Schau nach, wie hoch die JPM sind. Das ist die Anzahl der Jobs pro Minute. Und wenn Du es ein wenig laufen lässt, kannst Du auch sehen, wie es abgearbeitet wird.

Tuxi ⁂

•Das Loglevel ist auf Notice.

Hier die Ausgabe von ca. 30 Sekunden Laufzeit --> https://bin.disroot.org/?6d997e1fc1759f07#HC31ymKC8qBxfm8rjQ8AQ1e1MuURzffhnPMr6TmWsfph

Ein

tail -f /var/log/friendica.log | grep jpmbringt nach ca. 15 Minuten kein Ergebnis.Michael 🇺🇦

•Außerdem suche mal im Logfile nach Fehlern:

Tuxi ⁂

•Parameter habe ich gesetzt. Jetzt wird bei der Suche nach "jpm" was angezeigt:

https://bin.disroot.org/?93a01b2174c6b7b2#4kxNGCDm7fVVXGHykgn7Jo12PFV5w8mpvCJF9dB4Dcpq

Ein

cat friendica.log | grep ERROR.*"Uncaught Exception"bringt ne Menge. Hier ein Auszug: https://bin.disroot.org/?b67de8425308dd7a#2dG34fHLuuzcMNWgDA7CE3BnLoAHidjheVgtJahW9ki8Sorry aber das sind für mich böhmische Dorfer....

Michael 🇺🇦

•Die Worker-Zeilen sehen an sich gut aus. Das einzige ist, dass Du irre viele Einträge mit niedriger Prio hast. Aber ansonsten arbeitet Dein System alles recht gut ab.

Roland Häder🇩🇪

•Contact::getDefaultAvatar()'s erster Parameter ist in der Tat ein Datenfeld. Gucke dir z.B. die Zeile mitif (!empty($contact['id'])) {an. Dort wird$contactals Datenfeld verwendet.Tuxi ⁂

•Die Warteschlange hat sich zum Glück über Nacht abgebaut:

Habe eben auch ein "git pull" gemacht um die aktuellsten Änderungen zu haben. Die Worker verbrauchen immer noch extrem viel CPU:

Kann ich das mit der niedrigen Prio irgendwie beeinflussen?

Die "Uncaught Exception" werde ich jetzt mal ein paar Minuten tailen und dann in dem von Dir angegebenen Ticket berichten.

Tuxi ⁂

•Falls relevant (?) hier mal eine Momenaufnahme von "mytop":

https://bin.disroot.org/?4c5676b21998f786#6rEmZmXdCYSMwhr9BJucxaHgxrS6dcV6vfWttCwzezAz

Michael 🇺🇦

•Die anderen sehen sauber aus. Alle Queries, die praktisch keine Laufzeit haben (Spalte "Time") sind völlig okay.

Tuxi ⁂

•Danke Michael. Habe es jetzt mal deaktiviert. Werde weiter beobachten und berichten, ob es bzgl. der hohen CPU-Auslastung was gebracht hat.

Roland Häder🇩🇪

•renice 19 $(pidof php)"netter" zu machen, dann sollten diese weniger CPU-Zyklen verbrauchen und somit mehr fuer den Webserver und die Datenbank frei werden, was wichtiger ist (Frontend lahmt sonst). Hat keine Nebenwirkungen! 😀Tuxi ⁂

•Habe ich jetzt mal gemacht. Werde berichten.

Michael 🇺🇦

•jakob 🇦🇹 ✅

•Am Abend hab ich erneut ein Update gemacht, dann hat sich friendica wieder beruhigt.

Danke für den Fix!!

Tuxi ⁂

•tail -f /var/log/friendica.log | grep Load:folgende Einträge auf:... show more

tail -f /var/log/friendica.log | grep Load:folgende Einträge auf:Wie ich gestern gelernt habe, bedeutet dieses jpm "Jobs pro Minute". Deute ich die Logs richtig, dass keine Jobs laufen?

Das wäre aber im Widerspruch zu diesem:

Oder habe ich hier ein Verständnisproblem?

Michael 🇺🇦

•Tuxi ⁂

•Meinst Du "Uncaught Exception" ?

Wenn ja, dann läuft schon der ganze Abend ein "tail -f" drauf ohne Treffer.

Michael 🇺🇦

•Tuxi ⁂

•Hier die Übersicht der Prozesslaufzeiten:

Daraus habe ich mal die ersten beiden Workerprozesse genommen und die IDs "getailt":

Beide überschlagen sich mit ein und derselben Meldung:

... show more

Hier die Übersicht der Prozesslaufzeiten:

Daraus habe ich mal die ersten beiden Workerprozesse genommen und die IDs "getailt":

Beide überschlagen sich mit ein und derselben Meldung:

Ich deute mal das "item parent was not found" als nicht normal?

Michael 🇺🇦

•Tuxi ⁂

•Bin seit fünf Minuten auf den aktuellsten Dev-Stand. Mal sehen.

👤 𝟳𝗵𝗼𝗺𝗮𝘀 ✅🖖🔒

•Vielleicht wäre es einfacher wenn du für ein Produktivsystem immer die letzte final nutzt und nur fürs Testsystem ein Dev ?🤔

@Michael Vogel

Tuxi ⁂

•Hatte in den letzten Jahren nie ein Problem mit einer DEV. Aber ja es liegt in der Natur der Dinge, dass es ein Risiko ist.

Und so wie es bis jetzt aussieht, ist das System nutzbar. Es hat sich zumindest bis jetzt kein User beschwert.

👤 𝟳𝗵𝗼𝗺𝗮𝘀 ✅🖖🔒

•OK ... Das war nur ein Gedanke - spreche da ja aus Erfahrung als Programmierer... Ich habe da immer 3 Instanzen am laufen.

Ein Final und Produktivsystem

Ein PreFinal zum testen bevor es ins Final geht

Ein Entwicklungssystem (das schon öfters Mal nicht funktioniert)

Na wenn es wieder läuft dann ist gut 👍🏻

@Michael Vogel

Michael 🇺🇦

•👤 𝟳𝗵𝗼𝗺𝗮𝘀 ✅🖖🔒

•Booooohhh 😱

Hatte ja mir das auch schon Mal gezogen und den Quellcode durchstöbert... Aber nachdem man schnell seinen Account "verbrennen" Kann waäe mir das zu heikel.

Mein Dev system hab ich normalerweise immer auf einem proxmox laufen im Heimnetz und das live dann auf einem Server im Internet. Hast du Erfahrung wie Friendica auf einer lokalen Docker Instanz auf dem Entwicklungsnotebook laufen würde?

@Tuxi (Friendica) 🐧 ✅

Michael 🇺🇦

•👤 𝟳𝗵𝗼𝗺𝗮𝘀 ✅🖖🔒

•Michael 🇺🇦

•BTW: Die Verlagerung der Verarbeitung eingehender Nachrichten in das Backend hat wohl erst dazu geführt, dass wir Dinge wie diese Endlosschleifen überhaupt entdecken konnten. Frontend-Prozesse haben in der Regel maximale Laufzeiten, also werden diese z.B. nach 2 Minuten automatisch beendet. Da fällt es nicht auf, wenn das System sich zwei Minuten lang um sich selber dreht - im Hintergrund schon.

👤 𝟳𝗵𝗼𝗺𝗮𝘀 ✅🖖🔒

•Ja aber ich denke dennoch ist so ein Dev mit Vorsicht zu nehmen. OK wenn du das als git nimmst kannst du Zurückrollen aber ...nun ja widerspricht wohl meiner Ansicht von Software 😊

Tuxi ⁂

•Weder ein

renice 19 $(pidof php)noch ein Updaten auf die neueste Version haben eine Lösung gebracht. Nach wie vor 100 % CPU und eine Load von ~12jakob 🇦🇹 ✅

•Bei brachte schon das update gestern Abend DIE Erleichterung... der Server war zeitweise davor ganz außer Gefecht...

Michael 🇺🇦

•Hier sieht echt alles gut aus:

jakob 🇦🇹 ✅

•Die wurden dann aber sauber in wenigen minuten bis runter auf 0 abgearbeitet.

Tuxi ⁂

•Die CPU-Last waren stundenlang bei 100 Prozent und die Load bei ca. 27. Heute Morgen war dann die übliche Meldung im Backend, das seit xx🤐x kein Worker mehr gelaufen ist.

Habe eben um 08:55 ein erneutes git pull ausgeführt um wirklich auf dem neuesten Stand zu sein und das System neu gestartet. Nach dem Neustart dauerte es nur ein paar Minuten bis die CPU wieder knapp bei 100 Prozent war, nachdem die Worker losgelaufen sind. Aktuell ist die Load bei ~6 und die Warteschlange bei

2222 - 1451Werde die Kiste jetzt einfach mal laufen lassen....

Tuxi ⁂

•Auch ist die Ladezeit der Seite zähflüssiger.

Tuxi ⁂

•killall phpdie Workerprozesse neu zu starten. So bleibt anscheinend die Load in einem einigermaßen akzeptablen Bereich. Mal sehen....jakob 🇦🇹 ✅

•Michael 🇺🇦

•👤 𝟳𝗵𝗼𝗺𝗮𝘀 ✅🖖🔒

•kannst du nicht die PHP Prozesse begrenzen und auch den Speicherverbrauch?

Dann würde der Server wenigstens nicht mehr "am Rad drehen"

Tuxi ⁂

•Dann würden die Prozesse aber nicht neu starten, sondern in einer ewigen Schleife laufen.

👤 𝟳𝗵𝗼𝗺𝗮𝘀 ✅🖖🔒

•Du meinst wenn du die Laufzeit beschränkst für einen Prozess?

Tuxi ⁂

•Japp

Michael 🇺🇦

•Ich weiß nicht, ob er das Problem beseitigt, ich hoffe es aber.

Tuxi ⁂

•Tuxi ⁂

•P.S.: Dummer Frage: sobald der Status "Merged" ist, ist der Fix verfügbar, oder?

Roland Häder🇩🇪

•Montag

•Tuxi ⁂

•Nachdem ich gestern das Update gezogen habe, kamen auf einmal zigtausend Nachrichten in die Warteschlange, die auch heute Nacht abgearbeitet wurden.

Was die CPU-LAst betrifft, kann ich heute keine Besserung feststellen immer noch so zwischen 95 und 100 Prozent. Allerdings scheint die Load "akzeptabler" zu sein bei ~10. Allerdings immer noch nicht das gleiche Niveau wie vor der Änderung.

Die Oberfläche scheint jetzt nicht mehr so zäh zu sein.

Sagt mal, kann man diese Loops, von denen ihr sprecht, in den Logs erkennen?

Montag

•Michael 🇺🇦

•Montag

•Montag

•Ich habe mir einen lang laufenden Worker gesucht und im

friendica.logmal geschaut was der so macht. Ganz vieleNo valid network foundMeldungen und dann ist mir noch das hier aufgefallen:... show more

Ich habe mir einen lang laufenden Worker gesucht und im

friendica.logmal geschaut was der so macht. Ganz vieleNo valid network foundMeldungen und dann ist mir noch das hier aufgefallen:Da sowohl

gab.comals auchpawoo.netbei mir geblockt sind, sind mir diese beiden Einträge aufgefallen.Michael 🇺🇦

•ContactDiscoverywurde nicht geändert. Die kann nicht die Ursache sein.Montag

•Der jpm Wert im friendica.log liegt heute Abend auch deutlich höher als gestern. Keine Ahnung, ob sich da jetzt was beruhigt hat, aber meine Seite läuft und Uberspace beschwert sich auch nicht mehr bei mir dass ich zu viele Ressourcen verbrauche. 😉

Die durchschnittliche Load ist heute auch deutlich niedriger als gestern, wobei ich ehrlich gesagt nicht genau weiß, was mir der Wert

Load: 2.67/20aus dem Friendica Log sagen soll, ob das viel oder wenig ist.Michael 🇺🇦

•jakob 🇦🇹 ✅

•Tuxi ⁂

•Im

htopschaut das ganze folgendermaßen aus:Und hier die Entwicklung er Systemauslastung:

Hier sind die Logs zu den ersten drei Prozess-IDs aus dem htop Screenshot:

https://upload.disroot.org/r/gSegG4xz#RSwKYTncbeix/yOhy5Nl1jQDntfyOtMfNDqdXPWvKfQ=

https://upload.disroot.org/r/5MkhkEFE#ppGhN/U4YK/MhhNdZ6/TIgqbTO6o3Or8+eC1/wt6DwU=

https://upload.disroot.org/r/pE6WSghg#CJu3xl2mK4H6hF9PzW2iKS1MSqvMVSQWxOSduOAwHeY=

Softwarestand ist der von heute Morgen 07:30

Wenn Du weitere Infos brauchst gerne melden. Ich starte jetzt mal nichts neu und warte bis morgen früh.

Tuxi ⁂

•Hinweis: Der obige Kommentar mit den Screenshots und den Logs ist vor 10 Stunden erstellt worden und wurde bis jetzt nicht abgesendet. Habe jetzt sämtliche PHP-Prozesse, MySQL neu gestartet und ein git pull ausgeführt.

Hier der Zustand der Maschine von den letzten 24h:

Tuxi ⁂

•Irgendwie habe ich als Laie den Verdacht, dass es mit diesen massenhaften Einträgen zu tun hat?

[NOTICE]: item parent was not found - ignoring itemMichael 🇺🇦

•Tuxi ⁂

•Das ist der letzte Eintrag aus dem952435er log:

2022-08-02T20:00:26Z worker [NOTICE]: item parent was not found - ignoring item {"thr-parent-id":10381066,"uid":97,"worker_id":"68dcc88","worker_cmd":"Notifier"} - {"file":"Item.php","line":709,"function":"getTopLevelParent","uid":"f40d83","process_id":952435}Michael 🇺🇦

•Tuxi ⁂

•Und die drei anderen Logs die ich oben "angehängt" habe, haben ähnlich Einträge.

Michael 🇺🇦

•worker_cmd.Tuxi ⁂

•Wie man im Log sieht, gibt es über 22500Zeilen mit diesen Einträgen

"worker_cmd":"Notifier".Ich lass jetzt mal ein tail -f auf

"worker_cmd":"Notifier"mitlaufen. Einen Treffer hatte ich bereits kurz nach dem Start.Michael 🇺🇦

•Notifierist für die Auslieferung von Beiträgen zuständig. D.h. Du wirst ihn sehr häufig sehen. Die Frage ist, welche Worker-Kommandos Du zusammen mit der Meldung "item parent was not found" findest.Und ja, die Ursache des Problems ist augenscheinlich gut versteckt.

Tuxi ⁂

•Mache ein

tail -f /var/log/friendica.log | grep "item parent was not found" | grep "Notifier"Verstehe nicht ganz. Was meinst Du mit Worker-Kommandos? Auf was muss ich genau achten?

Michael 🇺🇦

•Tuxi ⁂

•Wie gesagt, bei dem 35er Log ist es massenhaft ein

"worker_cmd":"Notifier"Bei dem 60er ein

"worker_cmd":"ProcessQueue"Und bei dem 93er ein

"worker_cmd":"ProcessReplyByUri"Wie gesagt, das lässt sich in den drei Logs oben schön erkennen.

Michael 🇺🇦

•Tuxi ⁂

•cat /var/log/friendica.log | grep "item parent was not found" | grep "worker_cmd"interessant sein könnte? Achtung sehr groß. 😉Hier das Ergebnis:

https://upload.disroot.org/r/vEZwCnHM#JGvAMW/tC0Z4HNB4ft9UrUqvsAvIoi/FHzl9Q4zDkWg=

Montag

•Tuxi ⁂

•Und wie schaut es mit der Last aus? Also CPU und Load?

Montag

•Tuxi ⁂

•Hast Du Zugriff auf die Konsole und kannst mal für längere Zeit ein

htopausführen?Montag

•Montag

•Zumindest die Nachrichtenwarteschlange ist jetzt wieder bei deutlich unter 100.

Tuxi ⁂

•Hier eskaliert es auch gerade:

Montag (Backup)

•local.config.phpeinige Werte massiv verringert. Irgendwie ist das ziemlich der Wurm drinnen.jakob 🇦🇹 ✅

•Nur Dienstags wars arg.

Vielleicht probiert ihr den mal, statt worker aus der crontab...

Michael 🇺🇦

•Man muss dazu

'fetch_parents' => false,in der Config-Datei setzen.Tuxi ⁂

•Tuxi ⁂

•Habe jetzt so um die 10000 Einträge in der Warteschlange. Werde diese jetzt mal abarbeiten lassen und dann sehen wie es sich entwickelt.

jakob 🇦🇹 ✅

•Tuxi ⁂

•Ich meine das es dies als Systemeinstellung für eine ganze Instanz nicht gibt. So eine ähnliche Einstellung gibt es, glaube ich zumindest, in den Einstellungen eines Users selber.

Aber ich bin mir da überhaupt nicht sicher.... 🤔

Tuxi ⁂

•Du meinst diese Einstellunge, oder?

Werde die jetzt mal testweise deaktivieren....

Michael 🇺🇦

•Tuxi ⁂

•Hmmmm...... Also gefühlt hat die Änderung dieser Einstellung nichts gebracht. Allerdings ist der Load nicht so explodiert wie die Nacht davor, die CPU ist allerdings immer noch bei 97 Prozent im Schnitt.

Kann ich wieder auf die alte Einstellung von mir zurück oder soll ich diese für eine Analyse noch so lassen?

Michael 🇺🇦

•Tuxi ⁂

•Okay, dann stell ich wieder um.

Ping mich einfach an, wenn ich hier updaten und dann testen kann. 😀

Roland Häder🇩🇪

•Der Befehl

uptimegibt mir das hier:Und wenn nicht gerade sehr viele Anfragen auf meine Instanz einprasseln, ist mal gerade... show more

Der Befehl

uptimegibt mir das hier:Und wenn nicht gerade sehr viele Anfragen auf meine Instanz einprasseln, ist mal gerade eine CPU zum Drittel beschaeftit.

freesieht es bischen gruselig aus:Und ich glaube, ich muss mal meinem Server mehr RAM schenken, bzw. das Modell wechseln.

Tuxi ⁂

•Michael 🇺🇦

•Tuxi ⁂

•Genial 👍

Paula Gentle on Friendica

•Steffen K9 🐰

•Michael 🇺🇦

•fetch_by_worker,decoupled_receiver,max_recursion_depthundfetch_parents?Steffen K9 🐰

•- false

- 30

- false

Steffen K9 🐰

•Tuxi ⁂

•Sind das Werte in der config.php?

Steffen K9 🐰

•Rick

•Habe in der local.config.php nur die database config und system

Michael 🇺🇦

•fetch_parentsdeaktiviert? Zumindest mit dem letzten Stand des Systems sollte das der ultimative Killswitch sein ...Wenn die Last durch Worker verursacht wird, schau bitte nach, was diese ausführen. Das geht darüber, dass Du dir die Pid des jeweiligen Prozesses merkst und dann das Log nach dieser Pid durchsuchst.

Steffen K9 🐰

•Den Rest mache ich morgen. Müde. 😴

Michael 🇺🇦

•Damit läuft mein System absolut entspannt.

jakob 🇦🇹 ✅

•Michael 🇺🇦

•jakob 🇦🇹 ✅

•Michael 🇺🇦

•Tuxi ⁂

•Habe das jetzt auch so übernommen und werde berichten. Sollten diese Einstellungen nicht mit einem Update gesetzt werden oder wie ist das?

Michael 🇺🇦

•Steffen K9 🐰

•Steffen K9 🐰

•Für die selbe Prozess-ID ca. 70000 Zeilen wie diese...

... show more

Für die selbe Prozess-ID ca. 70000 Zeilen wie diese...

Michael 🇺🇦

•uri-id-Werte. Das hat also alles seine Richtigkeit hier.Tuxi ⁂

•Hier der Logauszug eines Prozesses der seit 5h 34m läuft:

Hier der von einem der seit 1h 34m läuft:

... show more

Hier der Logauszug eines Prozesses der seit 5h 34m läuft:

Hier der von einem der seit 1h 34m läuft:

Michael 🇺🇦

•Tuxi ⁂

•Wenn Du weitere Infos brauchst, dann melde Dich. Habe jetzt erst mal alles neu gestartet. Die CPU geht trotzdem sofort wieder auf 100 Prozent.

Tuxi ⁂

•Habe jetzt wieder Prozesse die seit über 5h laufen. Seltsamerweise finde ich zu den IDs keinerlei Einträge im Log.

Michael 🇺🇦

•Ich habe hier jetzt einen möglichen Fix für die Sache mit dem Notifier erstellt. Ich werde das über Nacht beobachten und dann einen PR erstellen.

Tuxi ⁂

•Das kann ich Dir leider nicht mehr sagen....

Tuxi ⁂

•Meine aber, dass es der worker -- no_cron war.

Aber ohne Pistole. 😉

Tuxi ⁂

•Heute Morgen die Kiste auf den aktuellen Stand gebracht.

Momentan wieder 100 Prozent CPU und lang laufende Worker:

Logs der einzelnen Prozesse:

3744920, 3744913, 3747202 und 3747200

3745011

... show more

Heute Morgen die Kiste auf den aktuellen Stand gebracht.

Momentan wieder 100 Prozent CPU und lang laufende Worker:

Logs der einzelnen Prozesse:

3744920, 3744913, 3747202 und 3747200

3745011

2022-08-17T09:14:21Z worker [NOTICE]: item parent was not found - ignoring item {"uri-id":10925024,"thr-parent-id":10925011,"uid":147,"callstack":"Item::insert, Item::storeForUser, Item::storeForUserByUriId, Item::storeForUserByUriId, Item::storeForUserByUriId, Item::storeForUserByUriId, Processor::hasParents, Processor::postItem, Receiver::routeActivities, Queue::process, ProcessQueue::execute, Worker::execFunction, Worker::execute, Worker::processQueue","worker_id":"0d50d2b","worker_cmd":"ProcessQueue"} - {"file":"Item.php","line":709,"function":"getTopLevelParent","uid":"ad2a34","process_id":3745011}Michael 🇺🇦

•jakob 🇦🇹 ✅

•Michael 🇺🇦

•jakob 🇦🇹 ✅

•Tuxi ⁂

•Habe vor ~ 4h das Update gemacht. Sage jetzt mal vorsichtig: Es schaut bis jetzt gut aus.

Ich glaube man sieht deutlich wann ich das Update gemacht habe und die Worker neu gestartet habe. 😉

Mal den Langzeittest abwarten.

P.S.: Soll ich im Log auf irgendwelche Auffälligkeiten achten? Wenn ja auf was? Begriffe?

Michael 🇺🇦

•Tuxi ⁂

•okay ich taile dann mal mit nebenbei.

Tuxi ⁂

•Michael 🇺🇦

•Tuxi ⁂

•Woran würde ich denn erkennen, dass es ein Fehler/Problem ist?

Michael 🇺🇦

•Montag

•max_processes_backendundmax_processes_frontendhabe ich auch wieder auf die Standartwerte gesetzt. Bis jetzt läuft es ohne Probleme.Tuxi ⁂

•Michael 🇺🇦

•Montag

•